整合人工智能的两大策略 [译]

人工智能(AI)预计将彻底改变我们的工作方式,为首批采用者带来显著的竞争优势。许多公司已经开始使用 AI 驱动的自动聊天机器人来处理客户咨询,但仍有些公司对这种新兴技术不够熟悉。这里面的关键问题是:这些应用中的 AI 效果如何?

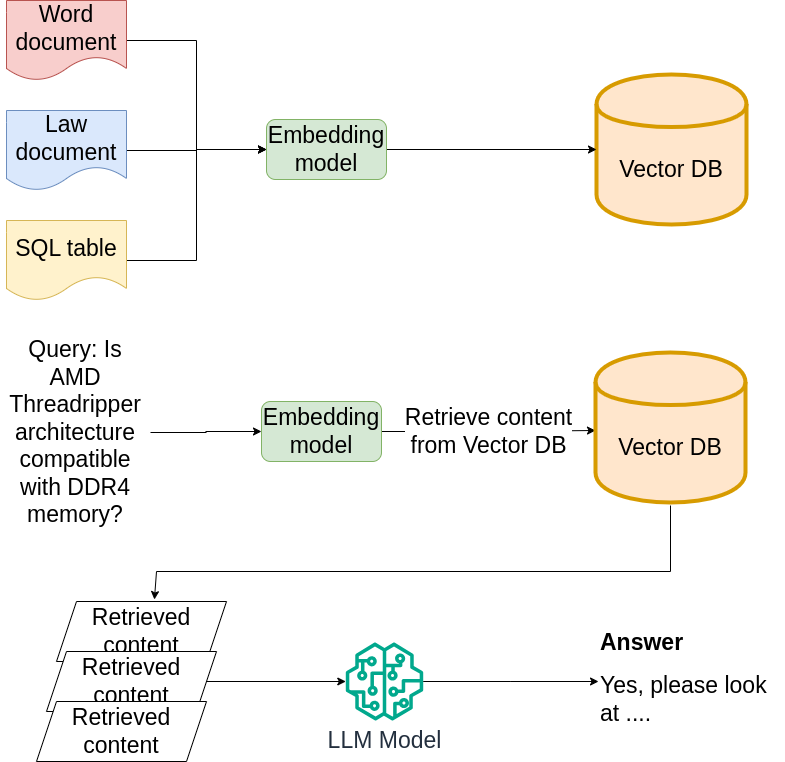

目前,像 ChatGPT 或 Google 这样的开放式大型语言模型(LLM)面临的一个挑战是对实时数据的访问受限。虽然有像 Bing 插件这样的例外,但即便如此,直接从自己网站上提取数据也不容易。不通过昂贵的模型微调就克服这个限制是个大挑战。而检索增强生成(Retrieval-Augmented Generation,RAG)技术或许能提供解决方案。

AI 与检索增强生成的整合

检索增强生成(RAG)是 AI 整合的又一革新技术。RAG 技术将像 GPT 这样的语言模型与外部知识源结合起来,使 AI 能够从数据库或文档集合中检索并利用事实信息。这种方法在 AI 应用中尤其有用,原因包括:

- 提高准确性和相关性:RAG 让聊天机器人能够访问大量信息,确保回答不仅与上下文相关,还事实准确。这对于需要具体详细信息的技术支持查询尤其重要。

- 动态知识库:不同于依赖预训练知识的传统 AI 模型,装备了 RAG 的聊天机器人可以从外部资源获取最新数据。这意味着它们能够提供有关产品、服务和政策的最新信息,并能在无需重新训练的情况下适应变化。

- 个性化客户体验:通过访问客户数据(在适当的隐私保护下),RAG 能够根据客户的历史或偏好定制回答,从而增强客户满意度,使回答更符合个人需求和过往互动。

- 成本效益的更新:对于快速发展行业来说,保持 AI 模型知识库的最新性是个挑战。RAG 通过访问最新的外部数据库来解决这个问题,减少了频繁重新训练模型的需求。

- 可扩展性和多样性:RAG 可应用于各种客户支持场景,从简单的 FAQ 互动到复杂的问题解决任务。它的适应不同类型查询的能力使其成为客户支持的多功能工 continue 具。

自主智能体在 AI 整合中的重要性

在 AI 应用中整合自主智能体可以显著提升交互质量。这些智能体能够处理复杂的问题,提供定制化的回答,并从每次互动中学习以持续改进。此外,它们能够自主推理和思考,减少对人工干预的依赖,从而扩大企业的客户支持能力。

随着 AI 的进步,这些自主智能体将变得更加先进,提供前所未有的支持水平。

自主智能体的发展是 AI 的一大飞跃,例如 Langchain 智能体等系统。这些智能体代表了一种更高级的 AI 互动形式,不仅仅是回应问题,而是积极参与多步骤推理过程。这个过程通常包括以下几个阶段:

- 问题理解: 智能体首先全面理解客户的问题,这涉及解析问题,以获得关键信息和上下文。

- 思维过程: 与传统聊天机器人不同,自主智能体会进行内部思考。它考虑问题的各个方面,结合其培训和可用数据。这可能包括将问题分解成子问题、构建不同假设或检索相关信息。

- 观察: 智能体接着寻找必要的额外信息。这可能通过类似 RAG 模型的外部知识库获取,或通过内部逻辑和推理系统完成。这一步对于需要最新信息或复杂多面的问题至关重要。

- 思维综合: 在收集所有必要信息后,智能体综合其思考,结合最初的问题理解和观察阶段中获得的新见解。这是智能体形成连贯回答策略的关键步骤。

- 最终回答: 最后,智能体提供其回答。这不仅仅是基于预设脚本的答案,而是经过智能体“思考”过程形成的,更加贴合用户的具体问题。

AI 整合的实际案例

研究 AI 技术在实际应用中的效果是理解其实际影响和能力的最佳方式之一。我们研究的案例,从客户支持到财务分析、法律援助,展示了 AI 在不同行业中的动态性和多样性。这些案例不仅展示了 AI 提升效率和准确性的潜力,还强调了其能够为满足特定行业需求而量身定制的特点。

客户支持

场景: 一家零售公司在其网站和移动应用中整合了 AI 驱动的聊天机器人,以处理客户咨询。

实施: 该聊天机器人采用类似 GPT 的模型,经过训练,可以理解并回应广泛的客户问题,从订单追踪到退货和换货处理。AI 可以进行自然的对话式互动,全天候提供即时回应。

技术应用 continue:

- 大型语言模型,用于自然语言理解和生成。

- 集成 API,将聊天机器人与公司的客户服务数据库和订单管理系统连接起来。

数据分析与报告

场景: 金融服务公司运用 AI 分析市场趋势,编制全面的报告。

实施: AI 系统输入大量金融数据,包括市场走势、股票历史表现和经济指标。通过分析这 continue 些数据,它识别出模式,构建预测模型,并据此制作出详尽报告,报告中包含对市场行为、风险评估和投资机会的深入分析。

应用技术:

- 高级数据分析工具和算法,用于识别模式和建立预测模型。

- 大语言模型 (Large Language Model),用于生成流畅、详实、易懂的报告。

- 结合 AI 的数据可视化工具,以易于决策者理解的格式展现研究成果。

法律领域 AI 助理的整合

场景: 一家法律公司引入 AI 驱动的法律助理,协助律师进行研究和案件准备。

实施细节:

- 法律研究: AI 助理能迅速查阅庞大的法律数据库,检索相关的法规、案例法和先例。它理解律师的自然语言查询,使律师能以普通英语提问,获得精确的法律参考资料。

- 案件分析: AI 工具根据提供的信息(如案件事实、相关法域等),分析具有类似情况的历史案件,提供法院过去裁决的见解,并指出过去有效的关键法律论点。

- 文档起草: AI 助理协助撰写法律文档,如诉状、合同和法律通知,建议使用在类似案件中有效的措辞,并确保符合当前的法律标准和格式。

- 客户互动: AI 工具可基于客户咨询提供初步法律咨询,处理常规法律问题,快速指导客户,使律师能集中精力处理更复杂的任务。

应用技术:

- 自然语言处理 (NLP) 用于理解和响应法律咨询,以及起草文件。

- 法律数据库集成,以获取最新的法规、案例法和法律文章。

成本效益分析

许多中小企业渴望加入生成式 AI 的浪潮,却在评估其成本效益方面遇到难题。目前,他们面临两种主要选择:使用 OpenAI 的 ChatGPT、谷歌的 VertexAI 或 AWS 等提供的付费云服务,或选择如 Mistral AI 7B 或 LLaMAv2 这样的开源工具,后者目前可免费用于商业用途。但选择开源模型需考虑托管成本和潜在的大量 GPU 服务器资源,尤其是在模型微调时。

OpenAI 表示:

- 我们不会在 ChatGPT Enterprise 或我们的 API 平台上使用您的数据进行训练

- 您拥有您的输入和输出数据(法律允许范围内)

- 您可控制数据的保留期限 (ChatGPT Enterprise)

那么,如何验证这些声明?许多公司对此可能持谨慎态度。

敏感数据公司的 AI 转型之路

全球公司在向 AI 服务商如谷歌、亚马逊或 OpenAI 提供个人等敏感信息时,可能面临遵守 GDPR 等隐私法规的挑战。存在这些数据不慎被纳入训练集或泄露的风险。对这些公司而言,使用定 continue 制的大语言模型 (LLM),无论是从头开始基于自身数据训练,还是从公众模型如 Facebook 的 LLaMa v2 和 Mistral 进行微调,都是一个可行的选择。

在自有硬件或云硬件上运行推理

企业还可以选择在自有硬件上或通过云计算解决方案本地运行开源和免费的 AI 模型。云平台提供扩展性和成本效率等优势,尤其适用于不定期的计算需求。例如,使用 AWS 的 Lambda/Step 功能,企业可以实现灵活的云端运算。考虑到像 LLamaV2 这样的模型,它们使用量化的权重。在 vast.ai 等网站上,人们可以找到 A100 GPU,价格低至每小时 1 美元。根据 NVIDIA 的介绍,A100 GPU 能以每秒 11 句的速度输出结果,这是非常引人注目的性能。

GPT 提供商的成本分析

理解集成 AI,尤其是 OpenAI 提供的大语言模型 (LLM) 如 GPT 对企业和软件工程师的成本至关重要。以下是 GPT 的定价概述。

OpenAI GPT-4 的定价

OpenAI 的 GPT-4 模型采用基于 token 的计费方式。这里的“token”是指一段文本,大致相当于四个字节。GPT-4 的定价结构如下:

Google Vertex AI 定价

Google Vertex AI 则采用基于字符的模型来为其 AI 服务定价,包括 Gemini 等 AI 模型的定价。该模型根据输入和输出的每千个字符进行计算,费用根据使用的服务和模型的不同而有所变化。

| 模型/价格 | 1000 字符输入 | 1000 字符输出 |

|---|---|---|

| OpenAI GPT 4.0 8K 范围 | 每 1000 个 token 0.03 美元 | 每 1000 个 token 0.06 美元 |

| OpenAI GPT 4.0 32K 范围 | 每 1000 个 token 0.06 美元 | 每 1000 个 token 0.12 美元 |

| OpenAI GPT-3.5 Turbo 4K 范围 | 每 1000 个 token 0.0015 美元 | 每 1000 个 token 0.002 美元 |

| OpenAI GPT-3.5 Turbo 16K 范围 | 每 1000 个 token 0.003 美元 | 每 1000 个 token 0.004 美元 |

| Google PALM 2 文本 | 每 1000 个字符 0.0005 美元 | 每 1000 个字符 0.0005 美元 |

| Google PALM 2 聊天 | 每 1000 个字符 0.0005 美元 | 每 1000 个字符 0.0005 美元 |

在 OpenAI 的 GPT 模型中,一个 token 通常相当于大约 4 个字节(或字符)。这意味着,一个单词往往由多个 token 表示,具体取决于其长度。

结论和未来展望

随着 AI 技术在客户支持、法律和金融服务等多个行业的融合与应用,我们可以清晰地看到它的变革潜力。在充分利用先进 AI 技术的同时,确保数据隐私和遵守 GDPR 等法规,这种平衡至关重要。不管是通过付费服务还是开源平台引入 AI,都需要谨慎考虑 continue 成本、效率和数据安全性。

展望未来,AI 在商业领域的融合和应用预计将快速发展。根据特定行业需求定制化大语言模型(LLM)的趋势,加上在确保数据隐私方面的不断进步,有望加速这一进程。此外,向更经济的 AI 解决方案转型,例如使用云服务或本地硬件运行 AI 模型,反映出 AI 技术的普及趋势。

随着 AI 技术的日渐成熟,我们期待看到更加复杂和先进的应用出现。这些应用不仅将提高运营效率,还将在预测分析、个性化客户体验和自动化决策等领域推动创新。因此,AI 在商业领域的未来不仅承诺提升效率和可扩展性,还将开辟新的战略增长和竞争优势途径。

总结来说,企业在引入 AI 的过程中必须处理好利用 AI 力量与保护数据隐私之间的复杂平衡。这一过程虽然充满挑战,但它为数字时代的创新和增长提供了广阔的可能性。

关于医疗设备和 AI 的未来展望,我们已在先前的文章中详细介绍,心脏健康领域的相关内容可以在此处找到。

如果您对此有任何疑问,或想尝试一下,欢迎在下方留言。更多个性化咨询或开始合作,请发送电邮至 contact@smartsolve.eu。